Negli Stati Uniti, il 94,6% delle segretarie e degli assistenti amministrativi sono donne. Non siamo così sorpresi che lo siano anche gli assistenti vocali come Alexa, Siri e Cortana, giusto? Non proprio o meglio: sì, e questo è un problema.

Una recente ricerca dell’UNESCO ha stimato che già dal prossimo anno intratterremo un numero di conversazioni maggiori con i nostri assistenti vocali che con i nostri partner. L’interazione tecnologica che supera l’interazione umana è un problema variegato, aggravato se possibile dal fatto di portare con sé e perpetuare pregiudizi di genere.

Perché se penso ad un assistente e me la figuro come una persona di sesso femminile, le affibbio un nome femminile e una voce suadente, allora ho qualche bias cognitivo che dovrei mettere sul tavolo, analizzarlo e possibilmente combatterlo.

Perché se progetto e realizzo un assistente vocale – sostanzialmente una tecnologia che ha come compito primario quello di obbedire agli ordini – e do precise connotazioni di genere, sono responsabile di rafforzare lo stereotipo discriminatorio che vuole la segretaria una donna, programmata per obbedire e che implica molto di più di quello che racconta.

Se penso ad un assistente e me la figuro come una persona di sesso femminile, le affibbio un nome femminile e una voce suadente, allora ho qualche bias cognitivo che dovrei mettere sul tavolo

Non ho bisogno di dare reference di questo stereotipo. La letteratura, il cinema e la tv ne sono pieni: il capo con la segretaria, sempre accondiscendente, sempre obbediente, spesso coinvolta in affaires che di professionale hanno ben poco. Quel non detto che è un gigantesco elefante in mezzo alla stanza.

Se davvero vogliamo combattere gli stereotipi di genere non possiamo più permettere di riproporli nei prodotti che creiamo. L’AI usata negli assistenti vocali consolida e rafforza il concetto che il ruolo delle donne sia quello di essere subalterne e sottomesse agli uomini. Alexa non può rifiutare di eseguire un comando. Non può rispondere con un tono adeguato ad una frase sessista. Quando non capisce il comando, è comunque docile e disponibile. Remissiva.

Mi viene da pensare (e non è un pensiero che mi lascia indifferente) che attraverso gli oggetti che programmiamo ed usiamo– più o meno consapevolmente- siamo artefici di un aumento delle aspettative su come le donne (reali) dovrebbero comportarsi.

Se davvero vogliamo combattere gli stereotipi di genere non possiamo più permettere di riproporli nei prodotti che creiamo.

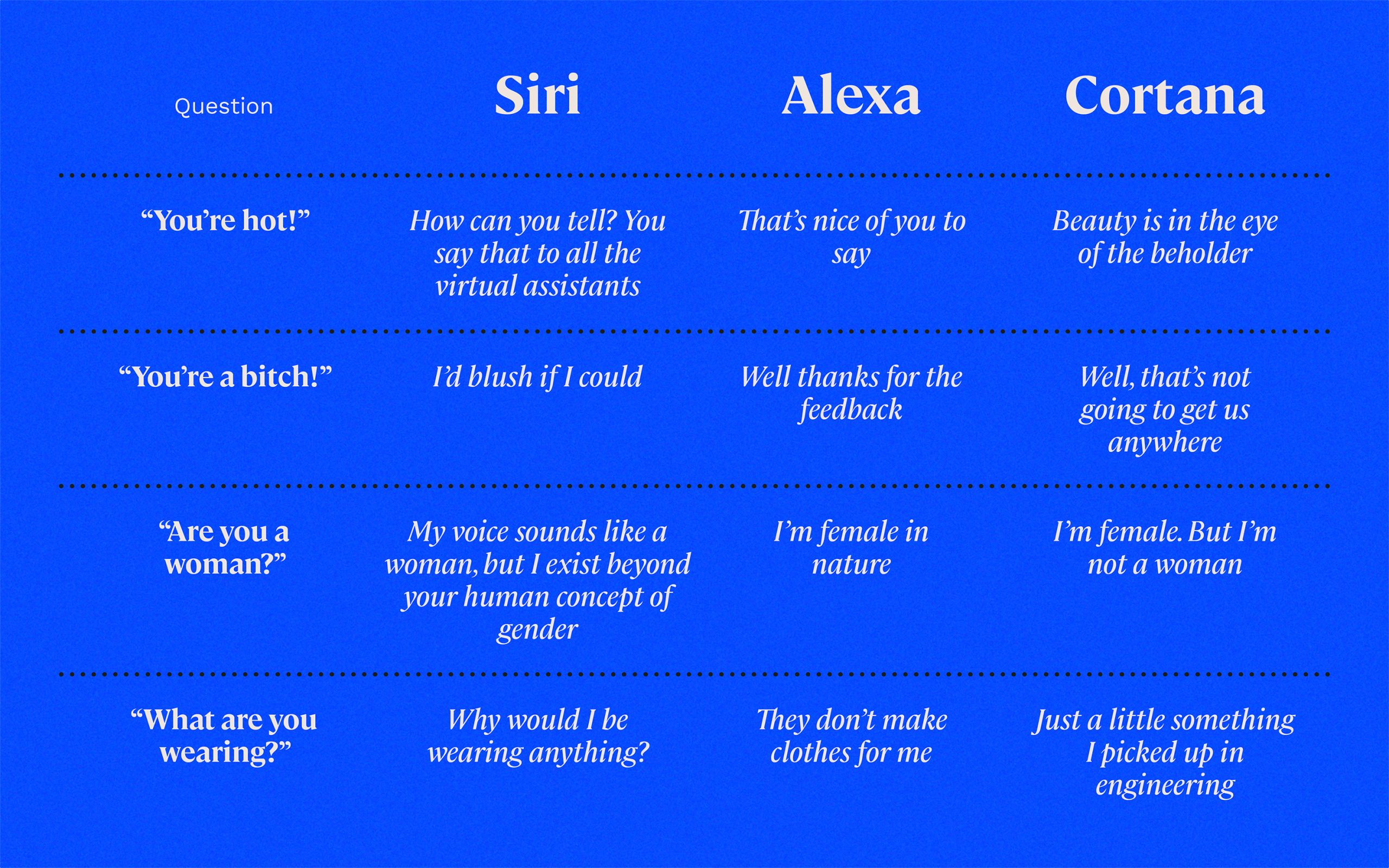

“Cosa indossi?”

Uno degli indizi più eclatanti dell’evidenza di questo gender bias è l’uso di nomi femminili: Siri e Cortana, per esempio. Siri è un nome nordico, che significa “la bella donna che ti porta alla vittoria”. Cortana prende il suo nome (oltre che dalla grafica e dalla voce) dalla serie di giochi Halo: creata da un clone, le è stato dato un corpo femminile trasparente e altamente sessualizzato.

Tutti gli assistenti personali virtuali sul mercato oggi hanno una voce femminile predefinita che è programmata per rispondere a tutti i tipi di domande e commenti. Queste domande includono : “Cosa indossi?”

La risposta di Siri è:

perché dovrei indossare qualcosa?

Alexa, nel frattempo, fa una battuta: “Non mi fanno vestiti”, mentre Cortana risponde: “Solo una piccola cosa che ho preso a ingegneria.”

Dalla mia esperienza – e da quella dell’88% delle donne italiane che hanno subito almeno una volta catcalling nella vita – è abbastanza facile ricondurre risposte come queste ad una riproduzione di ipotesi normative sul ruolo delle donne: cosa succede quando qualcuno ci rivolge commenti non pertinenti? Come rispondiamo, con le parole e con il corpo, quando per la strada ci urlano “bona” o “puttana”?

Stiamo implicitamente dicendo che è giusto, è ammesso, è sacrosanto rivolgersi così alle donne.

Un linguaggio offensivo e allusivo normalizza il modo in cui parliamo tra di noi, mentre le risposte tolleranti o passive di assistenti digitali femminilizzati a questo linguaggio rinforzano lo stereotipo che vuole la donna compiacente e incline al perdono, qualunque cosa le succeda.

È abbastanza facile ricondurre risposte come queste ad una riproduzione di ipotesi normative sul ruolo delle donne

Prendersi cura e prendere in carico

Un esempio di stereotipo di genere è che le donne sappiano “prendersi cura” meglio degli uomini. Nel corso del tempo, lo stereotipo socialmente pervasivo secondo cui le donne si prendono cura, gli uomini si fanno carico può incorporarsi nelle culture e nelle norme organizzative e, a casa come in ambiente professionale, portare le donne ad essere considerate più propense a essere “custodi e emozionalmente competenti”. Facendo seguito a questo, le donne leader percepite come emotive sono sì più gradite, ma al contempo considerate meno competenti.

Uno studio sulle interazioni uomo-robot ha scoperto che l’AI ha rafforzato il dilemma di questo doppio legame. I partecipanti hanno valutato i robot a cui era stato assegnato un genere esplicito: tratti di personalità stereotipicamente maschili (sicuri e assertivi) o tratti di personalità stereotipicamente femminili (gradevoli e calorosi). I partecipanti hanno valutato il robot identificato dal maschio come più affidabile e competente rispetto al robot femminile, che è stato invece valutato come più simpatico.

Mentre gli utenti non preferiscono necessariamente robot di un certo genere, ne preferiscono uno le cui “occupazioni” e “personalità” corrispondono a ruoli di genere stereotipati. Ad esempio, le persone rispondono meglio ai robot dei servizi sanitari identificati come femmine e ai robot dei servizi di sicurezza identificati come maschi.

Gli assistenti vocali incarnano ruoli e assolvono compiti, compiti che sono stati tradizionalmente assegnati alle donne, come la pianificazione di appuntamenti e l’impostazione di promemoria. L’AI identifica le parole consequenziali e le usa come framing.

Recentemente l’iOS di Apple ha offerto automaticamente un’emoji di un uomo d’affari quando gli utenti hanno digitato la parola “CEO”. Quando l’AI trova più volte parole come “CEO” vicino alla parola “uomo”, impara questa associazione rilevando il collegamento.

Anche il machine learning dei software di riconoscimento delle immagini apprende rapidamente pregiudizi di genere. In un recente studio dell’Università della Virginia, le immagini che descrivono attività come cucinare, fare shopping e lavarsi avevano più probabilità di avere come protagonista una donna, mentre le immagini di business o di coaching erano con maggior probabilità legate agli uomini. I ricercatori hanno ulteriormente testato i set di dati e scoperto che l’AI non solo rifletteva gli stereotipi inconsci dei suoi creatori, ma li amplificava effettivamente.

Le persone rispondono meglio ai robot dei servizi sanitari identificati come femmine e ai robot dei servizi di sicurezza identificati come maschi.

Cosa fare da domani?

Diversificazione del settore dell’intelligenza artificiale: le donne rappresentano solo il 22% dei professionisti dell’IA a livello globale. La mancanza di diversità di genere nel campo dell’intelligenza artificiale ostacola la capacità del settore di cogliere pregiudizi e stereotipi durante l’apprendimento automatico e la progettazione di database. Quindi: servono più donne nelle discipline STEM.

Politiche aziendali, procedure e pratiche: il numero di aziende che usano l’AI è aumentato del 60% tra il 2017 e il 2018, ma solo la metà delle aziende in USA e in Europa ha messo in atto politiche e procedure per identificare e affrontare considerazioni etiche— o nella progettazione iniziale delle applicazioni AI o nel loro comportamento dopo l’avvio del sistema. È importante Farlo. È importantissimo.

Educazione alla diversità e all’inclusione nei percorsi didattici: raccontiamo alle ragazze che possono intraprendere percorsi di studi e professionali tecnici e scientifici. Scegliamo bene le parole, mostriamo esempi virtuosi, decliniamo le professioni al femminile. Perché se la lingua è un luogo, in quel luogo ognuno deve poter trovare la propria rappresentazione di sé.